Nginx应用

1. Nginx基础

1. Nginx是什么

Nginx 是⼀个⾼性能的HTTP和反向代理web服务器,核⼼特点是占有内存少,并发能⼒强

2. Nginx应用场景

web服务器

性能⾮常⾼,⾮常注重效率,能够经受⾼负载的考验。

⽀持50000个并发连接数,不仅如此,CPU和内存的占⽤也⾮常的低,10000个没有活动的连接才占⽤2.5M的内存。

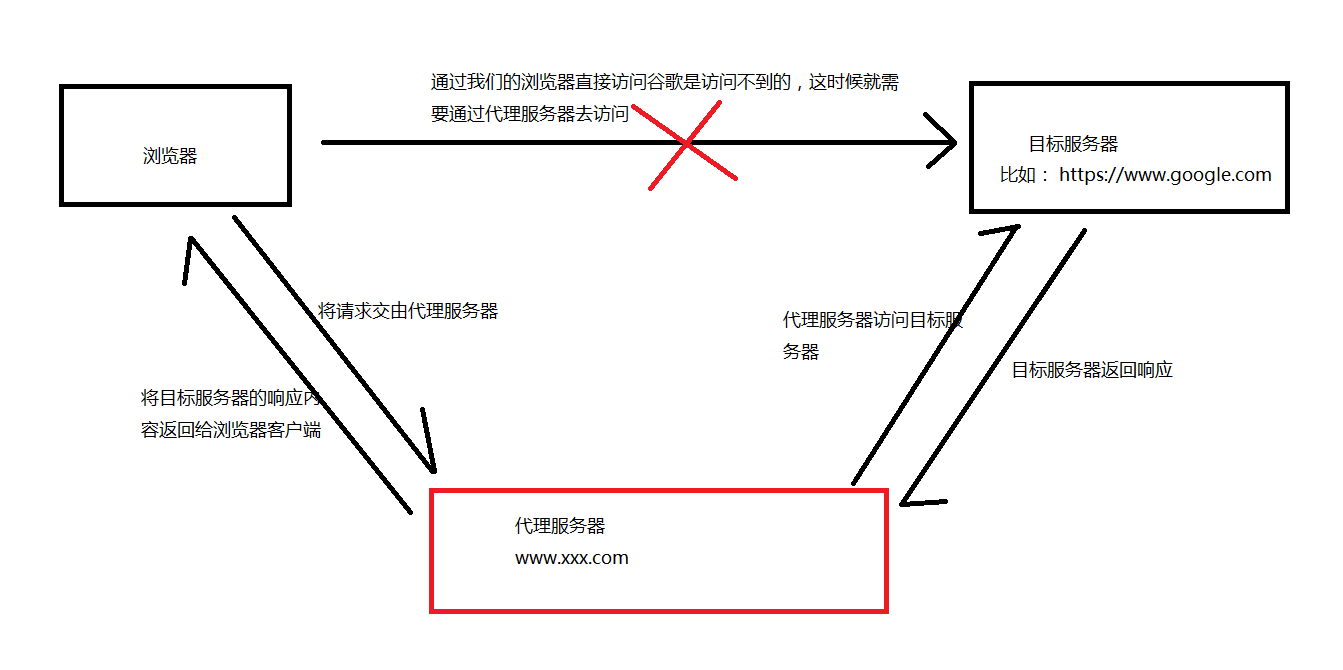

代理服务器

-

正向代理 在浏览器中配置代理服务器的相关信息,当浏览器发起请求时,会将请求请求交由代理服务器去访问,代理服务器收到目标服务器的响应后,会将响应信息返回给自己的浏览器客户端。

-

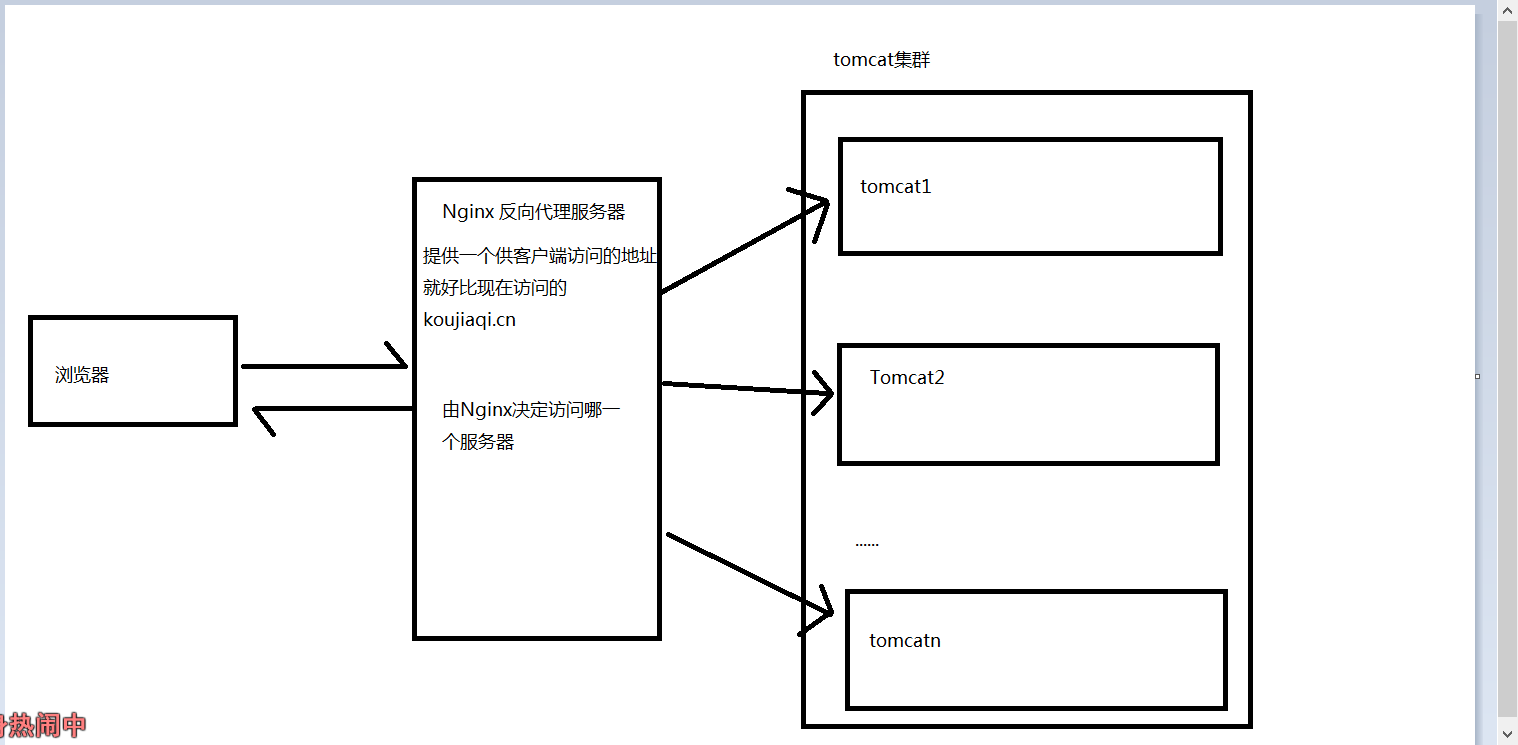

反向代理

浏览器客户端发送请求到反向代理服务器(⽐如Nginx),由反向代理服务器选择原始服务器提供服务获取结果响应,最终再返回给客户端浏览器

server {

listen 80;

server_name localhost;

location / {

proxy_pass http://127.0.0.1:8080/;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

负载均衡服务器

负载均衡,当⼀个请求到来的时候(结合上图),Nginx反向代理服务器根据请求去找到⼀个原始服务器来处理当前请求,那么这叫做反向代理。那么,如果⽬标服务器有多台(⽐如上 图中的tomcat1,tomcat2,...tomcatn),找哪⼀个⽬标服务器来处理当前请求呢,这样⼀个寻找确定的过程就叫做负载均衡。

⽣活中也有很多这样的例⼦,⽐如,我们去银⾏,可以处理业务的窗⼝有多个,那么我们会被分配到哪个窗⼝呢到底,这样的⼀个过程就叫做负载均衡。

负载均衡就是为了解决⾼负载的问题。

- Nginx负载均衡策略

- 轮询

默认策略,每个请求按时间顺序逐⼀分配到不同的服务器,如果某⼀个服务器下线,能⾃动剔除

- 轮询

默认策略,每个请求按时间顺序逐⼀分配到不同的服务器,如果某⼀个服务器下线,能⾃动剔除

upstream demoServer{ server 127.0.0.1:8080; server 127.0.0.1:8081; } location / { proxy_pass http://demoServer/; }

- weight

weight代表权重,默认每⼀个负载的服务器都为1,权重越⾼那么被分配的请求越多(⽤于服务器性能不均衡的场景),权重越高的越容易被访问

```shell

upstream demoServer{

server 127.0.0.1:8080 weight=1;

server 127.0.0.1:8081 weight=2;

}

- ip_hash

每个请求按照ip的hash结果分配,每⼀个客户端的请求会固定分配到同⼀个⽬标服务器处理,可以解决session问题

**在nginx版本1.3.1之前,不能在ip_hash中使用权重**

```shell

upstream demoServer{ ip_hash; server 127.0.0.1:8080; server 127.0.0.1:8081; }

- least_conn

最少连接数策略,将请求转发给当前连接数较少的服务器

```shell

upstream demoServer{

least_conn;

server 127.0.0.1:8080;

server 127.0.0.1:8081;

}

- fair (第三方)

响应时间方式, 按照服务器端的响应时间来分配,响应时间短的优先分配

```shell

upstream demoServer{ server 127.0.0.1:8080; server 127.0.0.1:8081; fair; }

- url_hash (第三方)

按照URI的hash方式分配请求,

```shell

upstream demoServer{

hash $request_uri;

server 127.0.0.1:8080;

server 127.0.0.1:8081;

}

静态资源服务器

tomcat中存在默认的 servlet : conf/web.xml

<servlet>

<servlet-name>default</servlet-name>

<servlet-class>org.apache.catalina.servlets.DefaultServlet</servlet-class>

<init-param>

<param-name>debug</param-name>

<param-value>0</param-value>

</init-param>

<init-param>

<param-name>listings</param-name>

<param-value>false</param-value>

</init-param>

<load-on-startup>1</load-on-startup>

</servlet>

任何请求都会经过默认的servlet,而servlet对静态资源都是经过DefaultServlet中的doGet() ---> serveResource() ----> ..... ----> copy()方法,把静态资源读入到输入流,返回到页面。

这一系列步骤首先会占用tomcat一个线程,处理过程也比较繁琐,会影响tomcat的性能。因此一般对于静态资源都会采用 擅长静态资源处理的服务器,比如Apache、Nginx

location /static/ {

root staticData; # root 会将 /static/ 拼接在staticData后

#alias staticData/; # alias 不会拼接

}

3. Nginx 的特点

- 跨平台:Nginx可以在⼤多数类unix操作系统上编译运⾏,⽽且也有windows版本

- Nginx的上⼿⾮常容易,配置也⽐较简单

- ⾼并发,性能好

- 稳定性也特别好,宕机概率很低

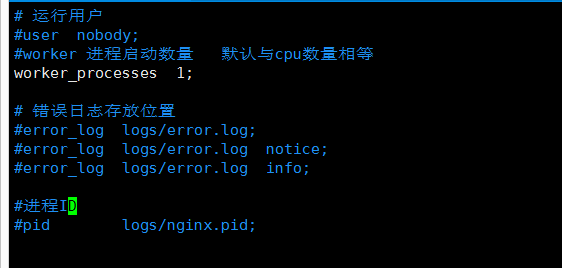

2. Nginx 核心配置文件

Nginx的核⼼配置⽂件conf/nginx.conf包含三块内容:全局块、events块、http块

2.1 全局配置:

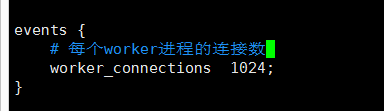

2.2 events

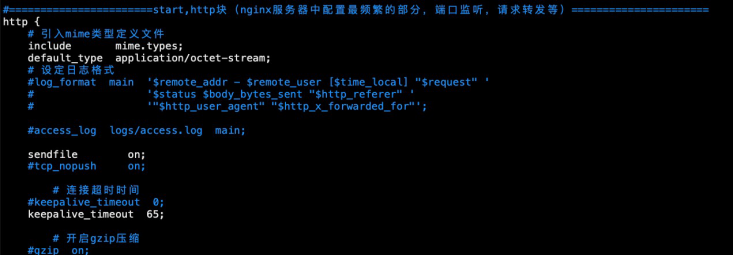

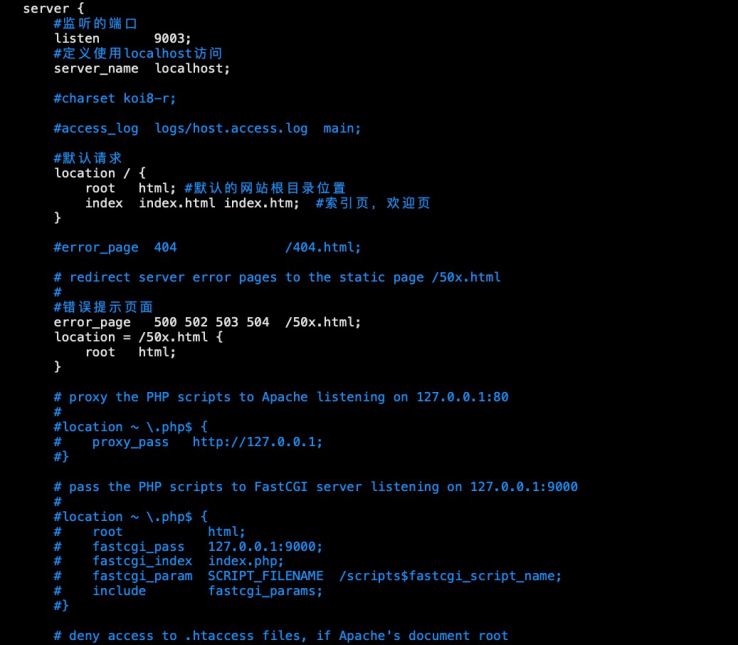

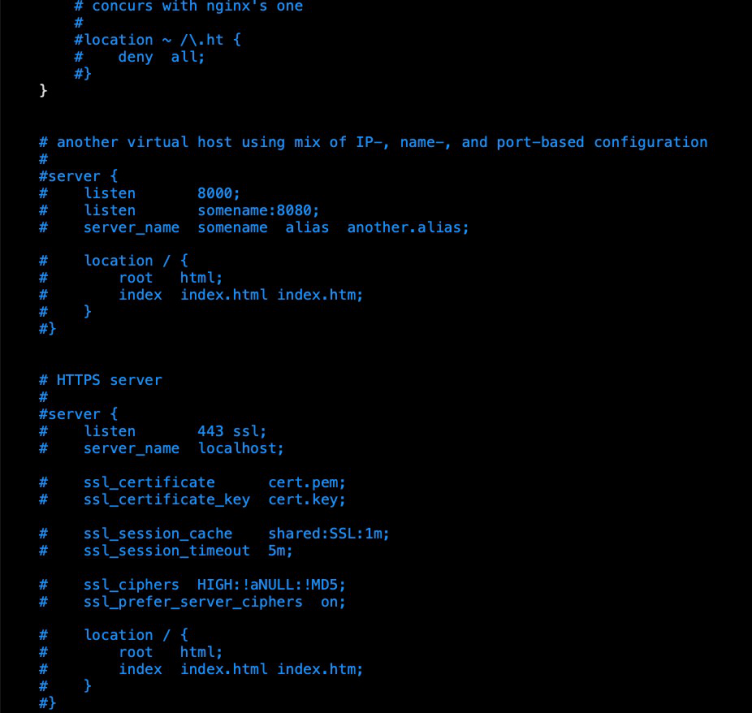

2.3 http

3. Nginx底层进程机制剖析

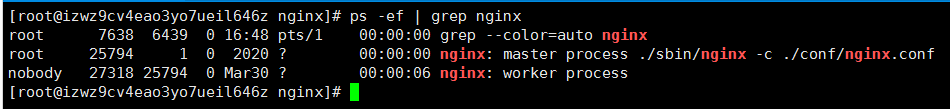

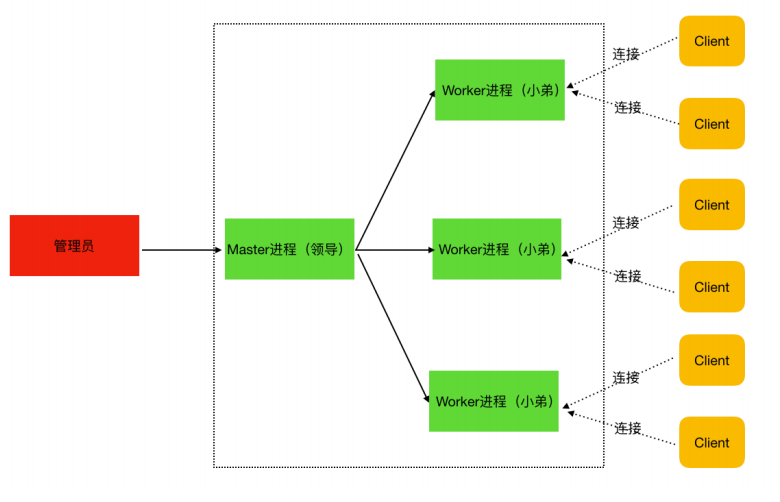

Nginx启动后,以daemon多进程⽅式在后台运⾏,包括⼀个Master进程和多个Worker进程,Master进程是主进程,Worker进程则是负责干活的进程

-

master进程

主要是管理worker进程,⽐如: 接收外界信号向各worker进程发送信号(./nginx -s reload) 监控worker进程的运⾏状态,当worker进程异常退出后Master进程会⾃动重新启动新的worker进程等

-

worker进程

worker进程具体处理⽹络请求。多个worker进程之间是对等的,他们同等竞争来⾃客户端的请求,各进程互相之间是独⽴的。⼀个请求,只可能在⼀个worker进程中处理,⼀个worker进程,不可能处理其它进程的请求。worker进程的个数是可以设置的,⼀般设置与机器cpu核数⼀致。

-

Nginx进程模型示意图

-

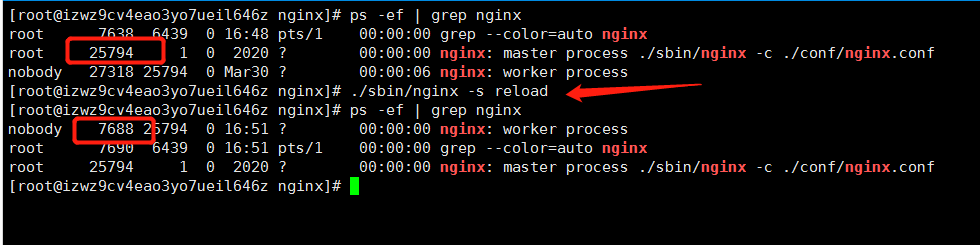

以 ./nginx -s reload 来说明nginx信号处理这部分

1)master进程对配置⽂件进⾏语法检查 2)尝试配置(⽐如修改了监听端⼝,那就尝试分配新的监听端⼝) 3)尝试成功则使⽤新的配置,新建worker进程 4)新建成功,给旧的worker进程发送关闭消息 5)旧的worker进程收到信号会继续服务,直到把当前进程接收到的请求处理完毕后关闭

图中可以看出, reload前后worker进程的ID是不同的

-

worker进程处理请求部分的说明

⼀个请求到来时,如果有多个worker进程,那么每个worker进程都有可能处理这个链接。

- master进程创建之后,会建⽴好需要监听的的socket,然后从master进程再fork出多个worker进程。所以,所有worker进程的监听描述符listenfd在新连接到来时都变得可读。

- nginx使⽤互斥锁来保证只有⼀个workder进程能够处理请求,拿到互斥锁的那个进程注册listenfd读事件,在读事件⾥调⽤accept接受该连接,然后解析、处理、返回客户端

-

nginx多进程模型好处

- 每个worker进程都是独⽴的,不需要加锁,节省开销

- 每个worker进程都是独⽴的,互不影响,⼀个异常结束,其他的照样能提供服务

- 多进程模型为reload热部署机制提供了⽀撑